|

Cho đến nay, trí tuệ nhân tạo (AI) vẫn được xem như một công nghệ mới mẻ gây phiền toái hơn là hữu dụng. Nhiều nghiên cứu chỉ ra rằng AI làm con người trở nên lười biếng hơn, và việc AI bịa ra các án lệ giả đã khiến một số luật sư bị kỷ luật. Nhưng nhìn chung, AI vẫn chưa thực sự trở thành mối đe dọa về an ninh quốc gia.

Điều đó nay đang thay đổi. Cuối tháng 10, hàng trăm nhân vật công nghệ hàng đầu - trong đó có đồng sáng lập Apple Steve Wozniak - đã ký thư kêu gọi Quốc hội Mỹ cấm phát triển “siêu trí tuệ” (superintelligence). Tuần trước, Giám đốc AI của Microsoft, Mustafa Suleyman, cũng tuyên bố việc theo đuổi siêu trí tuệ nên được xem là “một mục tiêu ngược”, vì đó không phải là viễn cảnh tương lai tích cực.

Những giới hạn của AI và sự hiểu nhầm về “trí thông minh”

Sự lo ngại của giới chuyên gia bắt nguồn từ việc xã hội đang chuẩn bị giao phó nhiều chức năng quan trọng - từ quyết định y tế đến điều khiển vũ khí - cho AI, với kỳ vọng AI có thể đưa ra quyết định nhanh và chính xác. Chính quyền các bang và thành phố ở Mỹ đã bắt đầu sử dụng AI để vận hành một số chương trình.

Tuy nhiên, các mô hình ngôn ngữ lớn hiện nay không bao giờ thực sự “thông minh”. Chúng chỉ là phần mềm nhận dạng mẫu, tìm kiếm câu trả lời từ dữ liệu có sẵn. Vì có quá nhiều dữ liệu sai trên mạng, AI đôi khi tạo ra các “sự thật” hoàn toàn bịa đặt - điều mà các luật sư kể trên đã phải trả giá. Các công ty công nghệ đã khôn khéo bán AI như một dạng “trí thông minh”, bởi điều đó tạo cảm giác đáng tin cậy. Nhưng trên thực tế, xã hội Mỹ đang trao quyền cho một công nghệ chỉ biết “đoán”, và nhiều khi đoán rất tệ.

Rủi ro an ninh quốc gia không ngăn được tham vọng của Big Tech

Những nguy cơ an ninh là quá rõ ràng. AI đưa ra quyết định dựa trên dữ liệu mà nó thu thập. Nếu đối thủ biết được AI đang dùng nguồn dữ liệu nào - và can thiệp, làm sai lệch dữ liệu đó - thì hệ thống AI gần như trở nên vô dụng, thậm chí có thể bị sử dụng để chống lại chính người vận hành mà họ không hề hay biết. Trên chiến trường tương lai, điều này có thể dẫn đến thảm họa.

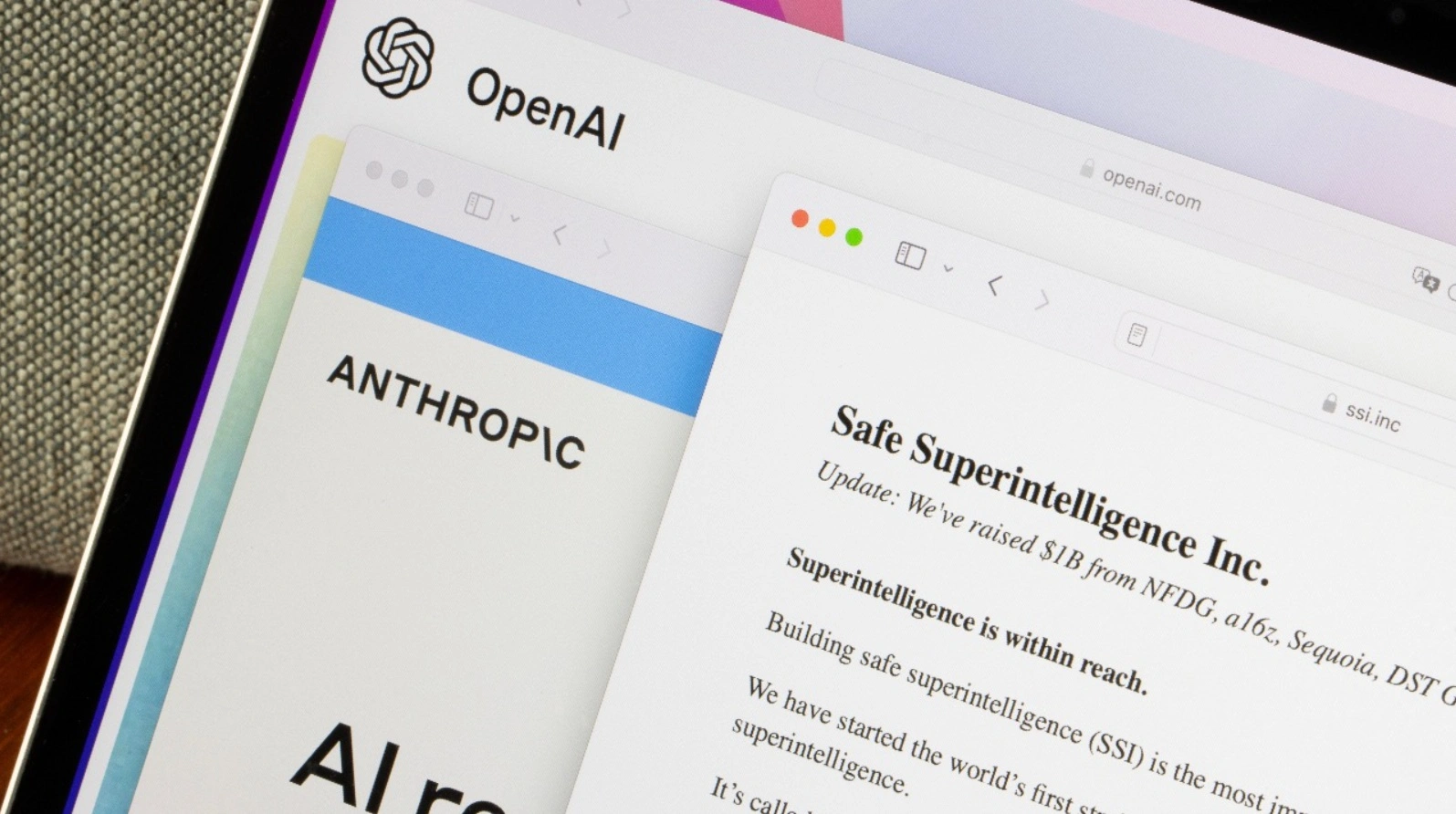

Tuy vậy, các công ty công nghệ lớn vẫn không chậm lại. Đặc biệt, công ty Safe Superintelligence Inc. đang theo đuổi một hướng tiếp cận mới đầy lo ngại. Đúng như tên gọi, mục tiêu của họ là tạo ra một “siêu trí tuệ an toàn”. Nhưng khác với các công ty AI khác, đây là sản phẩm duy nhất họ muốn phát hành. Công ty sẽ không công bố bất cứ thứ gì cho đến khi đạt được mục tiêu này; các cập nhật duy nhất từ trước tới nay chỉ liên quan đến nhân sự và các vòng huy động vốn.

Dù trang web đơn sơ chỉ gồm vài mục, Safe Superintelligence Inc. đã huy động được số tiền khổng lồ, đạt mức định giá 32 tỷ USD. Họ có hai văn phòng tại Palo Alto và Tel Aviv. Dù tự nhận là một “công ty Mỹ”, CEO Ilya Sutskever không phải công dân Mỹ, và hiện chưa rõ công ty có cam kết gì với chính phủ Mỹ hay không.

Điều này khiến giới quan sát đặc biệt lo ngại. Năng lực công nghệ Mỹ - nếu không ngẫu nhiên mà họ chọn đặt văn phòng tại Thung lũng Silicon – đang được sử dụng bởi một công ty bí ẩn để tạo ra một dạng trí tuệ có thể vượt qua con người và có thể được tung ra bất kỳ lúc nào mà không có cảnh báo.

Không chỉ vậy, đối thủ như Trung Quốc cũng đang phát triển công nghệ AI của riêng họ - trong khi chính phủ Mỹ gần như không nắm được tình hình phát triển trong nước.

Khoảng trống trong quy định quản lý AI của Mỹ

Nghe có vẻ như một bộ phim khoa học viễn tưởng thập niên 1990, nhưng điều này đang diễn ra ngay lúc này. Chính phủ Mỹ hiện không có cách nào buộc công ty phải tiết lộ họ đang làm gì. Điều này cần được thay đổi - và có những cách khá đơn giản.

Chính sách minh bạch AI của chính quyền Biden được xây dựng xoay quanh yêu cầu công khai thông tin đối với các công ty phát hành mô hình ngôn ngữ lớn mạnh mẽ (LLM). Nhưng cách tiếp cận này có một vấn đề lớn: không phải công ty AI nào cũng phát hành LLM mạnh. Một số cố tình tung ra các mô hình nhỏ, phục vụ mục đích cụ thể. Còn trường hợp như Safe Superintelligence Inc., họ không phát hành bất cứ thứ gì.

Giải pháp khá đơn giản: chuyển việc giám sát từ sản phẩm sang chi phí. Một đề xuất lập pháp do Dean Ball (Quỹ Đổi mới Hoa Kỳ, cựu Cố vấn cấp cao Nhà Trắng) đưa ra cho rằng mọi công ty AI có chi phí vượt quá 1 tỷ USD phải bắt buộc minh bạch hoạt động. Điều này sẽ đảm bảo các “ông lớn” AI hoạt động tại Mỹ phải công khai phần nào những gì họ đang làm, tránh việc một ngày nào đó công chúng Mỹ phải bất ngờ đối mặt với sự xuất hiện của một “siêu trí tuệ an toàn”.

An Lâm (Theo The National Interest)

Bình luận